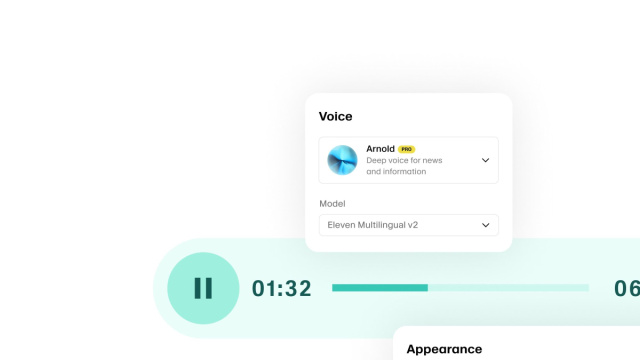

Al Web Summit di Doha, il co‑fondatore e CEO di ElevenLabs, Mati Staniszewski, ha delineato una roadmap che posiziona la voce come il prossimo principale punto d’interfaccia tra l’essere umano e l’intelligenza artificiale. Secondo Staniszewski, i modelli vocali, ormai dotati di emotività e intonazione, trascendono la mera emulazione della parola umana per dialogare con sistemi di linguaggio evoluto, ridefinendo così le modalità di interazione tecnologica. L’obiettivo a lungo termine è che i telefoni vengano riposti in tasca, permettendo alla voce di permeare il controllo tecnologico delle nostre vite, diventando un elemento quotidiano.

Un finanziamento da record per accelerare la visione

Il CEO ha annunciato un nuovo round di investimento da 500 milioni di dollari, che eleva la valutazione dell’azienda a 11 miliardi. Questa significativa iniezione di capitale, guidata da Sequoia Capital con la partecipazione di Andreessen Horowitz e Iconiq, testimonia la forte fiducia degli investitori nella rilevanza strategica della voce nell’era dell’AI.

Verso modelli vocali agentici e contestuali

Staniszewski ha sottolineato un passaggio evolutivo verso sistemi vocali “agentici”, caratterizzati da memoria persistente, contesto operativo e capacità di agire senza continue istruzioni esplicite. Questo scenario promette un processo conversazionale più fluido, meno oneroso per l’utente e intrinsecamente più naturale nell’economia del dialogo uomo‑macchina.

Collaborazione con Meta per un’AI onnipresente

Come anticipato al summit, ElevenLabs sta sviluppando un approccio ibrido cloud‑edge per il suo motore vocale, con l’intento di creare applicazioni integrate con dispositivi indossabili, come gli smart glasses. In particolare, l’azienda sta collaborando con Meta per integrare la sua tecnologia vocale in piattaforme quali Instagram e Horizon Worlds, aprendo la strada a interfacce AI sempre accessibili e pervasive.

La competizione sull’interfaccia vocale

Staniszewski ha posto l’esordio della voce come interfaccia al centro di una competizione già in atto, che vede coinvolti colossi del settore come OpenAI, Google e Apple, anch’essi impegnati nello sviluppo di modelli vocali avanzati o tecnologie always‑on.

Nel suo intervento, il CEO di Iconiq Capital ha evidenziato come, sebbene sia ancora presto per un abbandono totale di schermi e tastiere, questi strumenti stiano progressivamente perdendo la loro centralità, specialmente in contesti professionali ed espansivi.

Privacy e sorveglianza: le sfide della voce onnipresente

L’esplosione dell’uso vocale solleva inevitabilmente questioni cruciali legate alla tutela della privacy. Con la voce che si configura come un canale di comunicazione costante, potenzialmente sempre “ascoltato”, l’attenzione si sposta sulla raccolta dati, sulla sicurezza e sui possibili abusi. Staniszewski ha riconosciuto i rischi crescenti, citando le accuse già mosse a grandi aziende tecnologiche riguardo la gestione degli audio personali.

Il nuovo round di finanziamento rappresenta una scommessa sul futuro dell’input intellettuale. La voce come interfaccia — più intuitiva, accessibile e umana — suggerisce una svolta nell’ergonomia digitale, un cambiamento che impatterà non solo dispositivi e tecnologie, ma anche l’architettura delle interazioni quotidiane. Nonostante le sfide etiche e infrastrutturali ancora da affrontare, la traiettoria è chiara: la voce è destinata a diventare il linguaggio centrale dell’AI.